ビジネスシーンにおける活用状況や最新技術を解説しました

先日よりお知らせしていた「音×機械学習」をテーマとしたエンジニア向け勉強会、4月26日に無事第1回が開催されました。ゴールデンウィーク直前の金曜夜だったにもかかわらず、たくさんのご応募をいただき、また当日は夜になって雨がパラつきはじめるなか、開場前からお越しいただいた方も!会場も満員となり、熱気あふれる勉強会となりました。

EYSが進めているInspiartプロジェクトで音楽×機械学習の開発を手がけるR&Dエンジニア・金さんが講師をつとめる本セミナー。金さんはシンガポール国立大学大学院で機械学習を学んだのち、現地で就職し、オンライン広告の価格最適化ロジック生成や、自動運転車の位置検出時のノイズデータ除去などを手がけました。帰国後はR&Dエンジニアとして、機械学習による産業機械などの異常音検知を手がける企業を経て、EYSに入社。EYSではInspiartプロジェクトの中心的な存在として、「音楽×機械学習」の開発を進めています。

このセミナーでは、実際に産業面から音楽まで、音と機械学習というテーマに取り組んできた金さんだからこそ分かる「実際どういうデータを使うのか」「どんなアルゴリズムをどう組み合わせているのか」「どうやって精度をあげるのか」まで踏み込んで語ります!第1回は「産業面における音×機械学習の用途と現在」と題し、音楽に限らず現在のビジネスシーンで用いられている音に関する機械学習について解説。その様子をダイジェストでレポートします。

音声データを機械学習で扱うには?

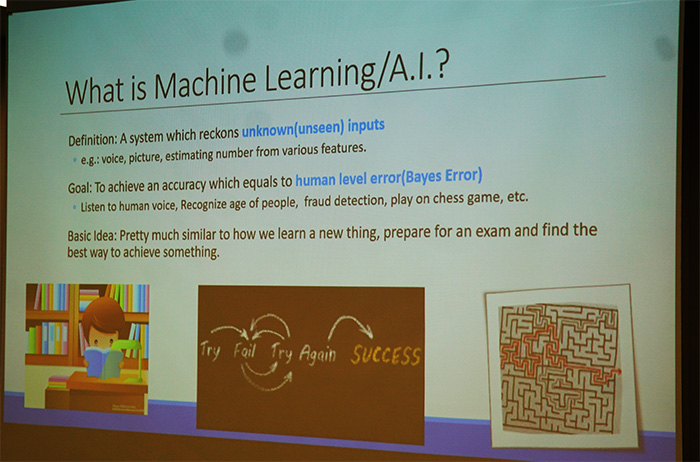

音と機械学習と言うと、すでにかなり一般的になっているGoogle HomeやAlexaといったVoice UI(音声認識)が挙げられますが、そのほかにも、コールセンターやインフラ整備の現場、工場などでも実用化が進んでいます。勉強会は、そもそもの機械学習の定義に加え、よく聞かれる「教師あり学習・教師なし学習」や「強化学習」「Deep Neural Network(DNN)」の基本をざっくりと振り返るところからスタートしました。

そして本題である「こういったモデルで音を扱うにはどうするのか」へとテーマを移します。

たとえば、音声認識の場合は、テキストデータとそれに対する音声がセットになった「Corpus」を用いて学習を進めるのだそう。日本で多く使われているのは「CSJ(日本語話し言葉コーパス)」。大学の講義をテキスト化したもので、会話情報も含まれ、800時間分の収録データとテキストが公開されています。そのほか、日本語の方言や会話などを録音したデータベースである「Speech Resources Consortium」も紹介されていました。外国語の場合は、韓国語、ヨーロッパ系言語、ベトナム語などが含まれる「LDC Corpus」が有名で、このなかにはウォールストリートジャーナルが作成した、英語で新聞を読み上げたデータも含まれます。

これらの音声データをそのまま学習にかけるわけではなく、MFCCという特徴量を用いて画像化し、処理していきます。特徴量をどう抽出するのか……といった点については、よく使われているツールキットとして「Kaldi」や「openSMILE」、また音楽系の解析で多く使われる「librosa」などを紹介し、特徴量作成の流れや画像化の方法、どうやって精度をあげるのかまで、詳しく解説しました。

「音」の分野で、今注目されている機械学習モデルとは?

では、音声認識では実際にどういった機械学習モデルが使われているのでしょうか?音声認識で成果を上げているDNNとしてConvolutional Neural Network(CNN)とLSTMが挙げられていましたが、実は、DNNが流行る以前、10年以上前はまったく違うモデルが用いられており、言語モデルと辞書、そして音響モデルをかけあわせたハイブリッドモデルで音声認識をおこなっていたのだそう。最近の論文では、すべてDNNで学習するEnd-to-Endモデルが多く登場しており、音声をシグナルのまま入れるのではなく、MFCCに変換してモデルに入れるやり方が主流になっています。今のところは音響に強いDNNモデルが多いものの、言語モデルを別途構築することで精度を高めるモデルや、言語モデルのDNNと音響モデルのDNNを掛け合わせることで精度向上を目指すものも登場しています。

そのなかでも、CNNとLSTMを用いたEnd-to-Endモデルが多く利用されているとのこと。今一番注目の領域と言えそうです。 さらに、Googleでも一時期採用されていた音声認識のモデルについて、インプットからアウトプットま で具体的なフローを解説!どこでどのモデルを使っているのか、どのように精度をあげるのか、雑音に強くするにはどうするのかといった実装まで詳しい解説があり、参加者の皆さんも熱心に聞いていらっしゃいました。

最先端の機械学習デモについての技術解説も!

その後は、コールセンターや、合成した音声で自然な会話をするチャットボット、インフラ異常音検知など、すでに実用化が進んでいるアプリケーションのデモ動画について、それぞれの技術的な背景とあわせて紹介。特に、レッスン予約についてAIが受け答えしている様子はかなり自然で、「ここまできているのか」と驚くほど。音×機械学習の最先端を 感じられるデモでした。

最後の質疑応答では、「今回はハンマーでの異常音検知が紹介されたが、人工衛星や無人ロケットなどで活用した例はあるか」という質問があがり、金さんから「宇宙空間では振動がなく、音がとれないため人工衛星などの例はない。乗り物についてはモーターの駆動音について実際に適用したことがあるほか、建物内における人の悲鳴などの異常音検知に使う例がある」と回答があって、勉強会は終了となりました。

「詳しい技術解説が参考になった」など嬉しい声も!

勉強会のあとは、会場を移し懇親会へ。今後ビジネスに音の機械学習を取り入れたいといった方から、これから機械学習を深く学んでいきたいという方、大学院生まで多くの方に参加いただきました。お酒とお料理をいただきながら、どの席でもさまざまな話題で盛り上がる会となり、「ここまで詳しく解説してくれる勉強会は珍しいので参考になった」「EYSは音楽教室のイメージが強く、こんなに機械学習に取り組んでいるのは知らなかった」といった声も。

勉強会の内容を掘り下げ、「どこまでの音を分析するのか、人が聞こえない音まで分析する価値はあるのか」などの議論も交わされたりと、有意義な時間となったのではないでしょうか。

金さんがリーダーをつとめるEYSのInspiartプロジェクトでは、機械学習エンジニアを募集しています。基本的な条件としては「機械学習やデジタル信号処理(DSP)の基礎が分かること」となりますが、そのほかの情報はこちらに詳しく紹介してありますので、ぜひご覧ください。現場の様子を金さんに聞いたところ「EYSは手を動かしてコードを書いてきたエンジニアが集まっていて、実際にコードを書く機会も多くあります。ゴールは共有したうえでやり方や手段は一人ずつに任されているので、すごく働きやすいです」とのこと。音楽とAIで未知の領域に挑むInspiartプロジェクト。興味を持った方はぜひご応募ください。

5月16日(木)に開催された第2回「音楽における音×機械学習の用途と現在」では、Inspiartプロジェクトのメインテーマである音楽にフォーカスし、詳しく解説しました。

第2回の様子についても、近日中にこちらのブログでお伝えしますので、お楽しみに!